英伟达推出代工业务:为客户定制部署超级模型

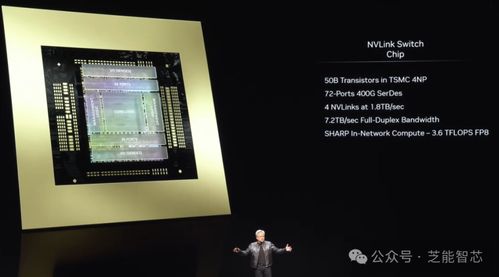

IT之家7月24日消息,英伟达公司昨日(7月23日)发布新闻稿,正式推出“NVIDIAAIFoundry”代工服务和“NVIDIANIM”推理微服务。

“NVIDIAAIFoundry”代工服务

英伟达表示客户可以使用Meta的Llama3.1AI模型,以及英伟达的软件、计算和专业知识,为特定领域定制构建“超级模型”。

客户可以利用专有数据、由Llama3.1405B和英伟达NemotronReward模型生成的合成数据来训练这些“超级模型”。

NVIDIAAIFoundry由NVIDIADGX™CloudAI平台提供支持,该平台与世界领先的公共云共同设计,为企业提供大量计算资源,并可根据AI需求的变化轻松扩展。

NVIDIAAIFoundry包括Nemotron和Edify等英伟达创建的AI模型、流行的开放式基础模型、用于定制模型的NVIDIANeMo™软件,以及NVIDIADGX™Cloud上的专用容量(由NVIDIAAI专家构建并提供支持)。

输出结果由NVIDIANIM(一个推理微服务,其中包括定制模型、优化引擎和标准API)负责,英伟达推出代工业务:为客户定制部署超级模型可以部署到任何地方。

NVIDIANIM推理微服务

IT之家注:NVIDIANIM是一套加速推理微服务,允许企业在云计算、数据中心、工作站和PC等任何地方的NVIDIAGPU上运行AI模型。

通过使用行业标准的API,开发人员只需几行代码就能利用NIM部署人工智能模型。NIM容器无缝集成Kubernetes(K8s)生态系统,可以高效地协调和管理容器化人工智能应用。

参考

免责声明:本网站部分内容由用户自行上传,若侵犯了您的权益,请联系我们处理,谢谢!联系QQ:2760375052