个人的标准,才是苹果发布会最高光的产品

9月10日,苹果的“高光时刻”如期而至,iPhone16系列以及AppleWatch10与Airpods4等熟悉的新面孔一一亮相。库克还在多个场合数次宣告,一个“激动人心”的“新时代”的开启。

这个新时代,是个人AI的时代,是“基于Appleintelligence从头设计”的,是对乔布斯在四十年前对ChatGPT的预言的呼应:人们可以向下一个亚里士多德提问,并得到答案;计算已经走向了个人计算时代,AI也会走向个人AI时代,这是历史的必然。

早在iPhone16系列之前,来自全世界的智能手机厂商,就已经进行了大量引入AI的尝试。8月,谷歌抢在苹果前面发布了基于Gemini模型与Android系统的Pixel9系列;中国智能手机厂商选择AllinAI,也已经纷纷发布自己的新品。

苹果在每一个新品类的诞生中,都不是冲在第一位的,但往往能交付最好的用户体验。它通过垂直整合软硬件的几乎所有环节,重新定义新品类的完整标准。这回,苹果也给出了“个人AI”的标准,总结一下,就是个人场景、个人数据、个人交互、端侧模型、端侧算力、隐私保护,在此之上创造个人表达、个人创造、个人效率,以及个人健康的用户体验。

个人场景(personalcontext)

是最贴近用户的应用场景,也是体量庞大但又为当下前沿大模型所有意无意忽略的应用场景。苹果拥有20亿设备及用户,其中超过10亿的活跃iPhone用户,每个人都拥有其独特的个人应用场景,包括其生活经历与使用习惯。

与公共场景不同,在个人场景下,个人是AI面向消费者的服务的主体,个人AI意味着AI可以根据用户个人场景来微调。而在公共场景下,个人只是AI面向企业的服务的,或是面向社交网络的服务的“分子”。公共场景下的,大模型无意的幻觉与使用者对生成的滥用,在惹恼不少用户的同时,进一步污染了大模型自我进化的空间。个人场景与个人AI,正是当下AI发展的最大空间。

在个人场景下,用户生成了海量个人数据

。它包括内容数据、交易数据,以及更底层的元数据。越来越多用户追求更大的储存空间,目前顶配的iPhone,本地储存空间都高至1T,这还没算上用户可以额外付费购买的iCloud服务。这些被用户所创造与分享着的内容,还有一层可以脱敏使用的“元数据”。用户拍摄照片时记录的拍摄地点、拍摄时间、编辑方式,以及佩戴耳机时环境音量与佩戴手表时的呼吸频次,都可以用来实现更为个人的用户体验。苹果还通过AppStore拥有用户的交易数据。伴生用户,并实时摄入用户数据,才是AI训练数据的最大源泉与活水。

相对的,公共场景的可用数据越来越紧缺。这一方面是可供训练的高质量数据接近上限,另一方面是因为。在与纽约时报等媒体打起官司后,OpenAI等大模型厂商不得不向多家媒体与社交平台采购公共数据;但是内容的原创者也不满意自己的权益由平台做了主。

隐私保护

成为了个人AI时代的重中之重。它是的部分,也是这次发布会上,个人的标准,才是苹果发布会最高光的产品苹果宣传AppleIntelligence时放在第一位的。苹果自研了本地模型,升级了本地算力,并通过隐私云

等技术将这层保护扩展到云端大模型。苹果正在参与对OpenAI新一轮融资,以增强自己在云端大模型合作中的话语权。

这次苹果发布会演示了不少AI功能,都是iPhone16本地生成模型

所提供的。它们由苹果自研,是参数规模在30亿左右的小型模型。今年以来,小型模型的性能正在迅速追赶大型模型。苹果动作频频,开源了OpenELM模型。连OpenAI创始成员卡帕西(AndrejKarpathy)也称,只要数据与技术得当,甚至小于10亿参数规模都可以形成自己的“认知核心”,成为个人本地设备上的“外部大脑皮层”。

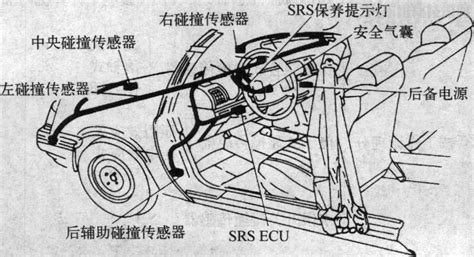

为了更快更省电地在本地运行这些模型,苹果也为最新机型升级了本地算力

,包括芯片、内存及其散热方案。其中,iPhone16/16Plus两款机型,直接从上一代的A16跳到了如今的A18,内存也升级到8GB,这将是端侧大模型本地运行的低配方案。而iPhone16Pro/ProMax两款旗舰机型,则采用了第二代3nm制程的A18Pro芯片,其中CPU与GPU的速度比上一代同一机型分别提升15%与20%,能耗降低了20%;NPU算力仍然是35TOPS,但内存带宽增加了近20%。

苹果的iPhone设计缺乏变化,已被外界诟病许久。它将精力主要放在了两大路线上,芯片与摄像头。如今,这两大路线通过新的个人交互

方式,交汇在一起,将成为个人AI的另一个入口。这次的新机型,新增了“相机控制”按键,它是机身侧面加入的,可以单击、长按与滑动的“微型触摸板”。

用户可以用它拍下一张活动海报,将其加入到自己的日历里。它缩短了用户触及摄像头的路径,也就是采集视觉语言的前端环节;又缩短了与应用之间的路径,也就是处理视觉语音的后端环节。前者是个人AI时代的眼睛,后者是个人AI时代的大脑。而“相机控制”就是个人AI时代的入口。未来,在Siri主要负责语音或者自然语言的个人交互之外,将由它来负责视觉语言的个人交互,拉近人类与现实世界的联系。

在这些基础之上,用户可以丰富个人表达,简化个人创造,提升个人效率。

用户可以在消息里输入描述,直接创建个性化表情符号(Gmoji),或者通过新应用“Playground”生成有趣的原创图片,并集成到iPhone各类应用中。

用户还可以输入文字描述来搜索照片并创建故事线,让用户“重温回忆”。这样的用例将随着个人AI与个人AI设备的进步而扩展。此前苹果就介绍过它的,未来无论是专业用户还是个人用户,多模态的个人创造的门槛与成本将大幅降低。

用户还可以使用新iPhone集成的写作与邮件等工具,总结来信摘要,转录音频内容,调整回复语气,校对文本措辞。

还有个人健康

,这是库克最为看好的领域。这次,苹果新推出的AppleWatch10与AirPods4,也具备了部分AI功能。新版watchOS能够检测睡眠呼吸暂停迹象,国家卫健委曾公布阻塞性睡眠呼吸暂停的国内患病率约为3%-7%,但患者往往不自知,都将一定程度上受益于这项AI技术的应用。更新后的AirPods则将新增听力保护、听力测试,甚至还支持临床等级的助听器功能。

尽管如此,苹果也有一些坏消息。这些用户体验不会随iOS18的第一个版本发布。AppleIntelligence将于2024年10月率先于美国上线,到12月底扩展至其他英语国家。汉语、法语、日语和西班牙语版本将于2025年逐步上线。但这还只是语言版本,在当地正式发售的“国行”版本,需要当地监管机构的批准。苹果中国官网提示,推出时间依监管部门审批情况而定。

AppleIntelligence也仍处于创新早期,相当于iPhone刚推出的那个阶段。当时,它的网络信号、内置电池都遭到了批评,应用生态也没有建立起来。AppleIntelligence短期也面临愿景大于现实的问题。

iPhone16也不会是iPhone4。苹果分析师郭明錤最新预测,iPhone16全系列在今年的出货最高8900万部,仍然低于上一代全系列的9100万部的订单量。

市场耐心正在逐步消散,苹果需要尽快为自己开启的个人AI时代,打磨出新品类的成熟形态。彭博社的马克·古尔曼(MarkGurman)称,到2025年秋天,iPhone17系列发布时,苹果才将可能处于更有利的地位。

最后总结一下。这次发布会的最大价值,是苹果定义和初步呈现了什么个人AI,以及它会带来的用户体验。正如当年苹果开创了个人PC的时代,如今苹果开创个人AI时代的努力,值得期待。